AIエージェント特有のリスクと対策

1.イントロダクション:使いこなせばチームを超えるが、無策では制御不能に

「AIエージェントを活用したい。でも、なんだか不安もある…」

そんな思いを抱えていませんか?

AIエージェントは、単なる生成AIではなく“自律的に業務を遂行する存在”です。使いこなせば人間チームのような働きを代替し、業務効率は飛躍的に向上します。しかし、その自由さゆえに、制御不能な事態や不透明な意思決定、セキュリティリスクが同時に浮上するのです。

この記事では、そんなAIエージェントの最新活用事例とそのリスク構造をわかりやすく解説し、明日から備えられる実践的な対策の考え方を紹介します。

本記事で分かること:

- AIエージェントの最新活用トレンドと仕組み

- 自律性の高さゆえに発生するリスクとは何か

- 企業が取るべきリスク対策の基本と実装の方向性

この記事を読み終える頃には、AIエージェントを“安心して使いこなす”ための戦略の全体像が見えているはずです。

2. AIエージェントとは何か?

2-1. 活用が加速する理由とビジネスへのインパクト

AIエージェントとは、「タスクを理解し、実行手段を自ら計画し、必要な情報を取得して、目的達成まで自律的に行動するAI」です。

特に注目されているのは、オーケストレーター型構成です。

これは以下のような複数のロール特化型AIを束ねる構造です:

この辺のオーケストレーションを実現する技術がMCPです。

- 調査エージェント → Webからデータ収集

- 整理エージェント → 構造化してDBに格納

- 生成エージェント → 報告書や図解を自動生成

- 実行エージェント → 社内ツールにAPI連携で反映

これはまるで人間の組織構造を模倣しているような設計です。

つまり、AIエージェントの活用は単なる自動化を超えて、「チームの代替」に近いインパクトをもたらし始めています。

2-2. 自律型とワークフロー型の違い

AIエージェントは以下の2つに分類されます:

- ワークフロー型:人間が定義した手順に従って動作

- 自律型:目的だけ与えると、自分でタスクを分割・判断・実行する

現在はこの“自律型”の進化が著しく、予測不能な行動も増えているため、リスクマネジメントの重要性も高まっています。

2-3. AIエージェントの登場と今後

すでに時代を一変させているAIエージェントも出てきました。

- Manus:ブラウザー操作によるさまざまなタスク遂行

- DeepResearch:学術論文の探索と要約、研究トピックの発掘

これらは単なるツールではなく、人間の専門職の知識補助・意思決定補助を担う存在です。

(ほんとにすごいので、ぜひ使ってみてください。)

つまり、AIエージェントは「使えば便利」から「使いこなさなければ遅れる」時代に突入しつつあります。

個人的な話になりますが、私自身も自律型のAIエージェントを自作しておりまして、簡単なアプリを一発出しできるようになりました。

これ、昔だったら2,3ヶ月かかるような作業です。それが数分で完成する時代です。恐ろしいです。

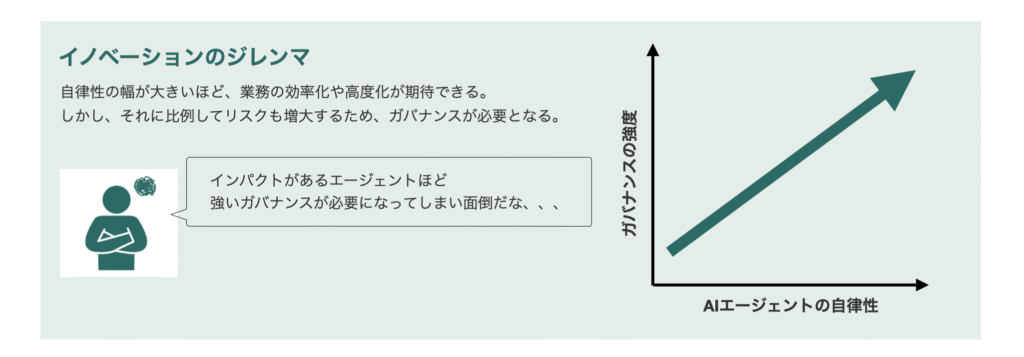

3. なぜガバナンスが必要なのか?

AIエージェントは、高度に自律的に動くからこそ、得られる成果も大きくなります。

ですがその反面、「人間が全体像を把握しきれない」ほどの自由さがリスクになります。

これはまさにイノベーションのジレンマとも言える構造です:

- ✅ できることが増えるほど

- ⚠️ 予期せぬことも増える

この相反するトレードオフの中で、企業は「自由にさせること」と「制御すること」の両立を迫られます。

つまり、AIエージェントを本当に使いこなすには“高度なガバナンス設計”が不可欠です。

4. AIエージェント特有のリスクと実務的対策

4-1. 正確性の欠如:

AIエージェントは毎回異なる判断を下します。これは適応力の高さでもあり、同時に“初期と異なる挙動”をし始めるリスクでもあります。

よくあるリスク:

- 長期タスク中にコンテキストが圧縮され、本来の目的を忘れる

- 単体テストでは問題なしでも、エージェント間の連携で精度が落ちる

- 自己改善ループにより、想定と異なる挙動に変化

対策例:

- タスク履歴ログと目的チェックロジックの導入

- 中間ステップでの「目的確認プロンプト」を必ず挟む設計

4-2. 判断根拠不明・責任の所在が不明:人間中心でない意思決定の不透明性

AIに業務を任せたとき、「なぜその判断を下したのか」が曖昧になる瞬間があります。

これは企業にとって重大なリスクです。

よくあるリスク:

- 出力内容の「判断根拠」が説明されない

- 「AIの提案をそのまま承認した」ことにより責任の所在が消える

対策例:

- 出力時に「根拠出力」を必須化するプロンプト設計

- 誰がどの出力に承認したかのトレーサビリティ記録

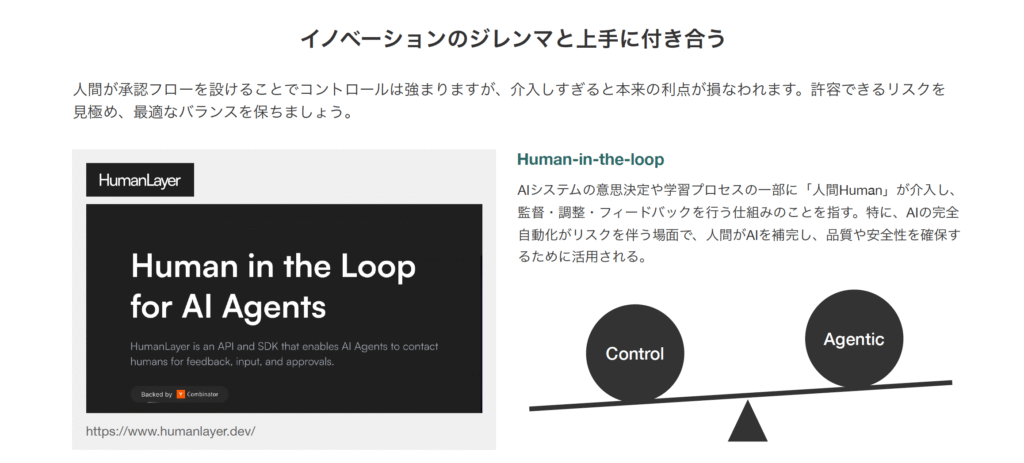

一方で、このような人間がAIの意思決定の承認を行う設計(Human in the loop ※)は、AIエージェントの自律性を奪ってしまう側面もあります。

したがって、人間がどの程度AIの意思決定に介在をするべきかは、リスクベースアプローチによる塩梅設計が必要です。

※ Human in the loop とは?:AIや機械学習システムの意思決定プロセスに人間が関与する仕組みのことを指します。特に、AIの予測や出力に対して人間が監督・補正・判断を加えることで、AIの性能向上やリスク軽減を図るために用いられます。

4-3. セキュリティリスク:従来のセキュリティ対応とAIセキュリティ対応の両方が必要

AIエージェントは外部APIやDBなどに接続するため、従来以上に権限管理・情報漏洩・操作不能リスクが拡大します。

想定されるリスク:

- 権限過多でDBを書き換えてしまう

- 有害プロンプトによるプロンプトインジェクション攻撃

- MCPサーバーからのレスポンスに有害なプロンプトが含まれている

対策例:

- IAM設計による最小権限設計

- インプットの検証層(毒性フィルタ/パターンマッチ)

- 実行ログ+アクティビティ監視(SIEM連携など)

ここで重要なのは、「AIエージェントのリスク対策はAI独自のガバナンスと従来ITの統制のハイブリッドが必要」という点です。

5. まとめ:AIエージェント活用のカギは「人材 × 制御設計」

AIエージェントの時代は、すでに始まっています。

活用すれば、チームの機能すら代替可能なレベルの生産性向上が見込めます。

しかし、それと同時に以下のような現実にも向き合う必要があります。

- 自律性ゆえに暴走する

- 判断の透明性が消える

- セキュリティ脅威が拡張されすぎている

これらはすべて「人が関与しないことによる影響」です。

だからこそ、本当に重要なのは“人間側の備え”です。

- AIのアウトプットを正しく評価できる承認人材

- 意図しない挙動を抑える制御構造

- 意思決定と責任を見える化する記録設計

AIエージェントは、人間と対立するものではありません。

人間が適切に設計・指導し、共に成果を出していく存在です。

だからこそ、導入時には「機能を見る」のではなく「使いこなす体制をどう作るか」に目を向けてください。

人間の役割は作業をする存在から、AIをマネジメントする存在に置き換わっていくのかもしれません。